Orbyta Tech a digital transformation company

Guidiamo le aziende nell’adozione di tecnologie all’avanguardia attraverso la nostra esperienza nello sviluppo software e nella gestione di dati, architetture scalabili e ambienti altamente complessi e dinamici.

I nostri servizi per fare crescere il tuo business

Grazie alla nostra esperienza decennale nell’ambito della consulenza informatica e sviluppo software offriamo soluzioni tecnologiche avanzate per rispondere a tutte le esigenze di innovazione dei nostri clienti.

IT consulting

Ti guidiamo nella scelta e nell’implementazione delle metodologie e tecnologie più adatte al tuo business grazie ad una competenza tecnica e di dominio del nostro team di consulenti IT.

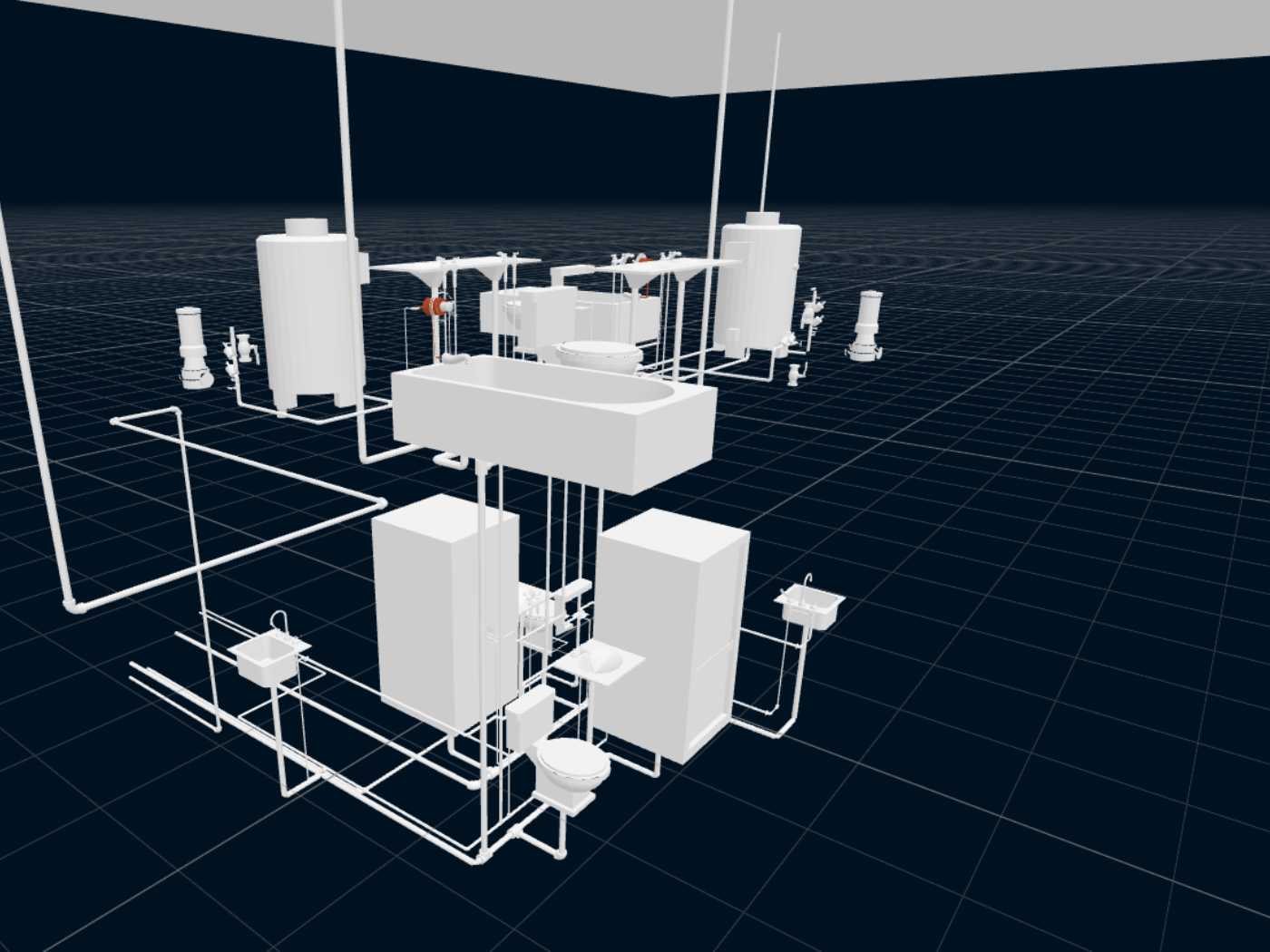

Software development and platform engineering

Sviluppiamo soluzioni software cross-platform potenziate dall’intelligenza artificiale e basate su architetture distribuite grazie ad una forte competenza nella gestione di dati e nelle metodologie agili.

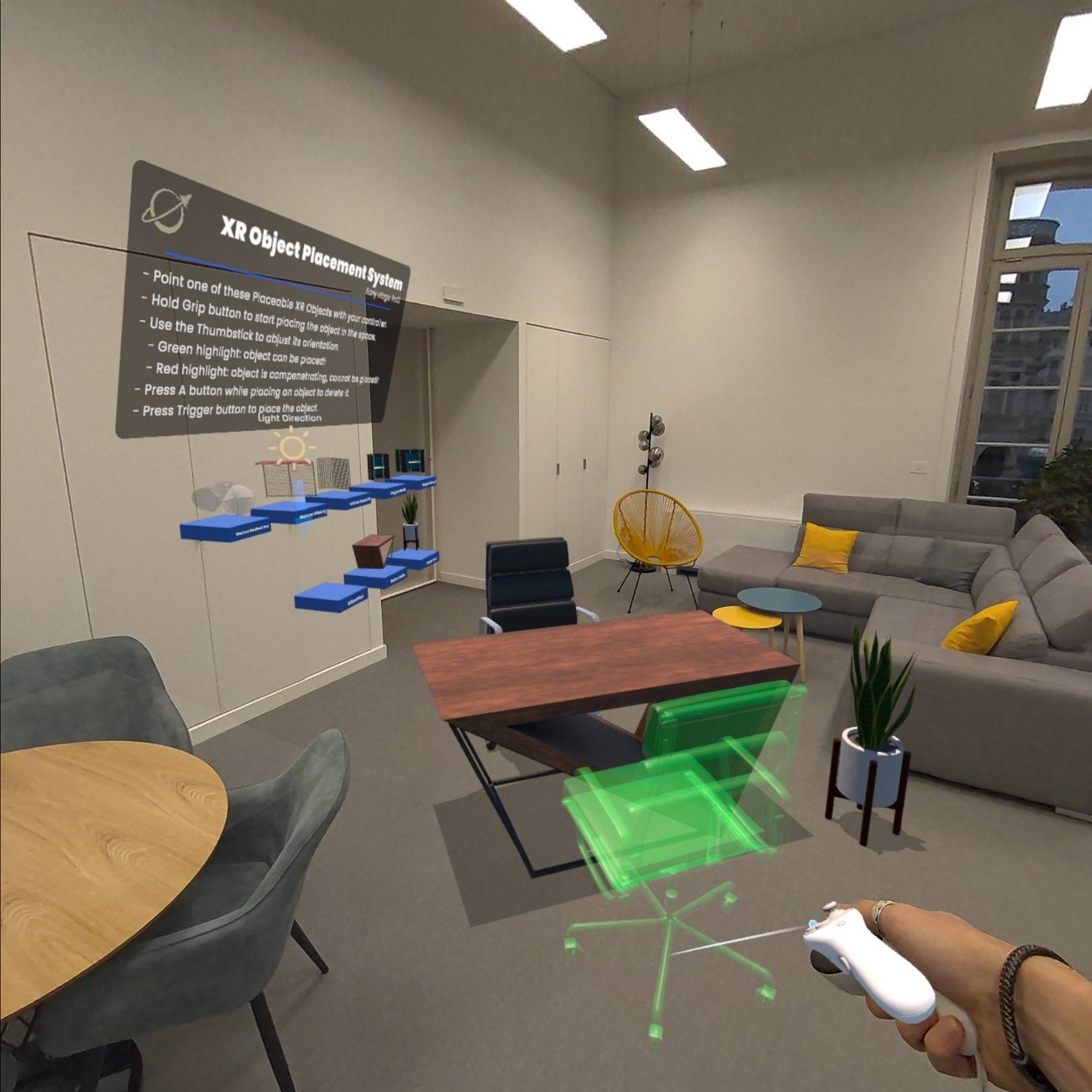

Design & Customer Experience

Progettiamo esperienze utente di applicativi e soluzioni digitali con uno sguardo alle tecnologie emergenti di AI generativa per la creatività e agli ambienti immersivi di mixed reality.

Data Management & Architecture

Progettiamo e gestiamo architetture scalabili e resilienti, integrando tecnologie avanzate per la raccolta, l’elaborazione e l’analisi dei dati.

IT Security & Infrastructure

Ci occupiamo della progettazione, implementazione e manutenzione sistemistica di reti aziendali e architetture complesse con i più elevati livelli di sicurezza. Siamo Microsoft Solution Partner for “Modern Work”.

Le tecnologie

Le certificazioni

ISO 9001: 2015

Nel 2019 il Gruppo Orbyta ha conseguito la certificazione del Sistema di Gestione per la Qualità.

ISO 45001:2018

Nel 2024 il Gruppo Orbyta ha conseguito la certificazione del Sistema di Gestione per la Sicurezza sul lavoro.

ISO 14001:2015

Nel 2024 il Gruppo Orbyta ha conseguito la certificazione del Sistema di Gestione Ambientale.

EN ISO/IEC 27001:2022

Nel 2022 il Gruppo Orbyta ha conseguito la certificazione del Sistema di Gestione per la Sicurezza dei dati.

UNI/PdR 125:2022

Nel 2025 Orbyta Tech ha conseguito la certificazione del Sistema di Gestione della parità di genere.

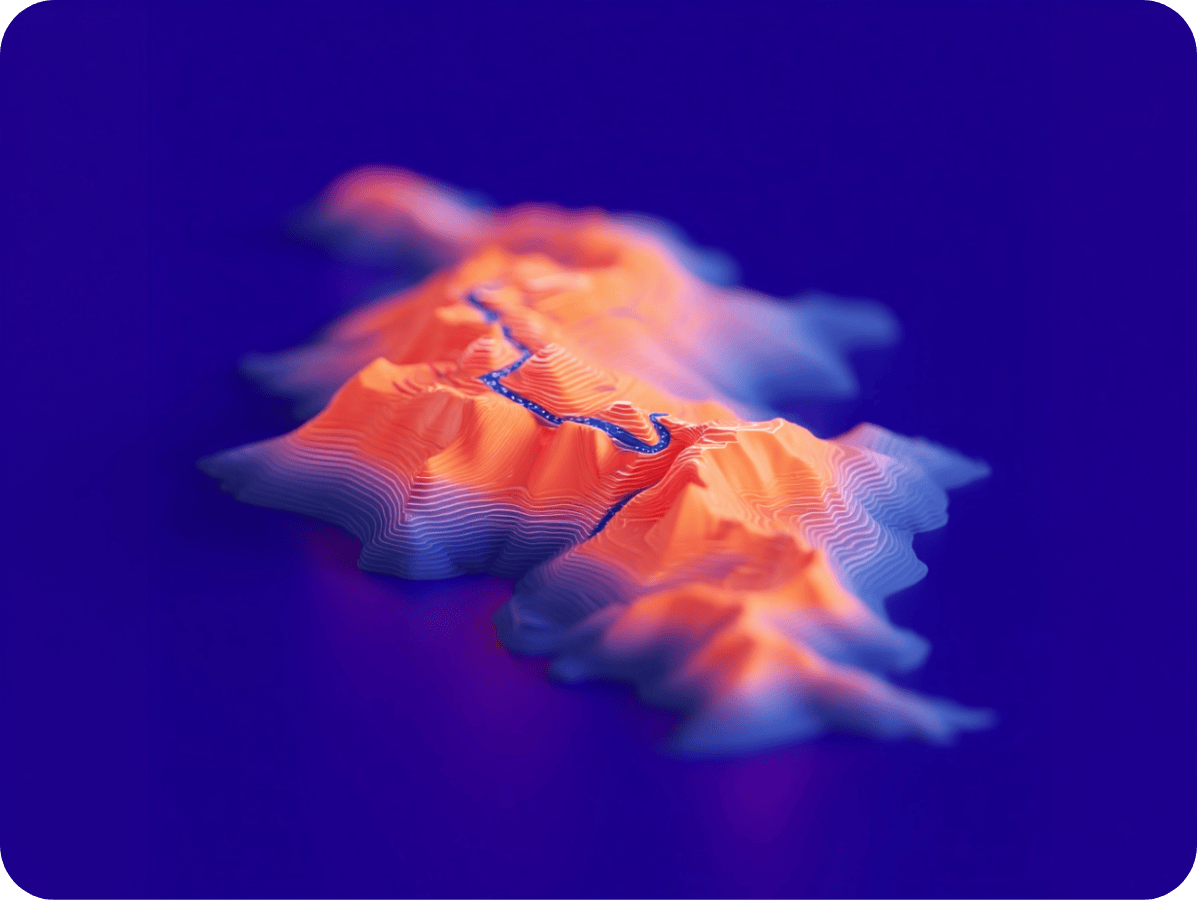

Immagini con l’AI generativa

Scopri come le tecnologie emergenti di intelligenza artificiale e mixed reality stanno innovando il tuo settore e quali sono le opportunità per aumentare il tuo vantaggio competitivo.

Leggi gli insights di Orbyta